产品设计

apache

python爬虫兼职

测试报告

自动化

嵌入式Linux SPI驱动

材质

decodeByteArray

websocket

ZYNQ

二分

IT企业管理基本概念

医学统计学

医学

computed

资损

四大分析工具

外贸独立站

渲染管线

二元操作符

对比学习

2024/4/11 17:11:01文献阅读:SNCSE: Contrastive Learning for Unsupervised Sentence Embedding with Soft Negative Samples

文献阅读:SNCSE: Contrastive Learning for Unsupervised Sentence Embedding with Soft Negative Samples 1. 内容简介2. 方法实现 1. embedding的获取2. soft negative样品的生成3. loss函数的定义 3. 实验 & 结果 1. 基础实验结果2. soft-negative样品的作用…

⑩【图神经网络×自监督×时空】视频自监督学习、时间对比图学习、多尺度时间依赖性(长期、短期) 、频域学习

你无法同时拥有青春和对青春的感悟。

最是人间留不住,朱颜辞镜花辞树。 🎯作者主页: 追光者♂🔥 🌸个人简介: 💖[1] 计算机专业硕士研究生💖 🌟[2] 2022年度博客之星人工智能领域TOP4🌟 🏅[3] 阿里云社区特邀专家博主🏅 🏆[4] CSDN…

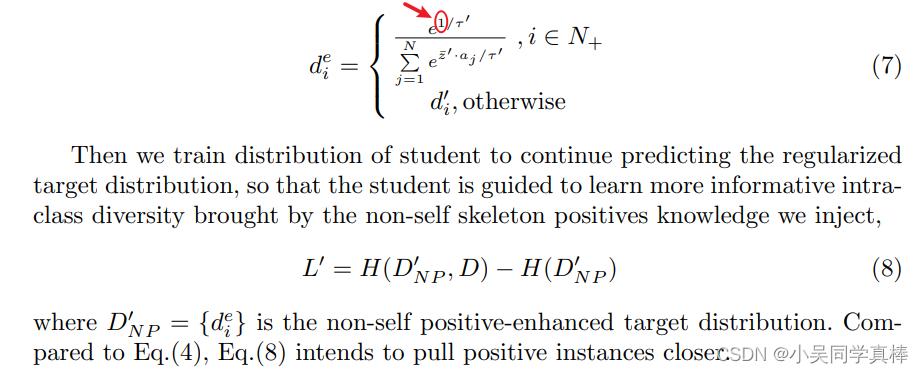

【论文阅读笔记】(2022 ECCV)Contrastive Positive Mining for Unsupervised 3D Action Representation Learning

论文题目:Contrastive Positive Mining for Unsupervised 3D Action Representation Learning

论文下载地址:https://arxiv.org/pdf/2208.03497.pdf 目录

0. 论文简介 & 创新点

1、Contrastive Positive Mining (CPM)

2、Similarity Distributio…

Contrastive Learning NLP Papers

文章目录对比学习聚类(Contrastive Clustering)Dropout来实现对比学习的数据增强(SimCSE)多模态运用对比学习用对比学习来优化句子向量的表示小batch_size的对比学习损失函数https://zhuanlan.zhihu.com/p/363900943上方链接有两个论文:解决N…

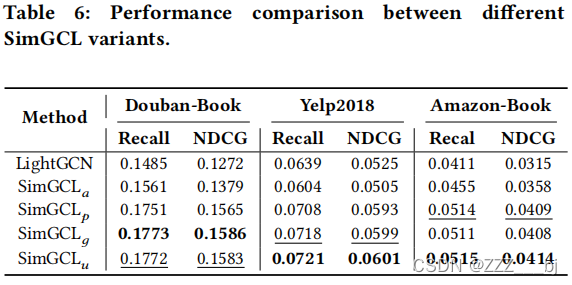

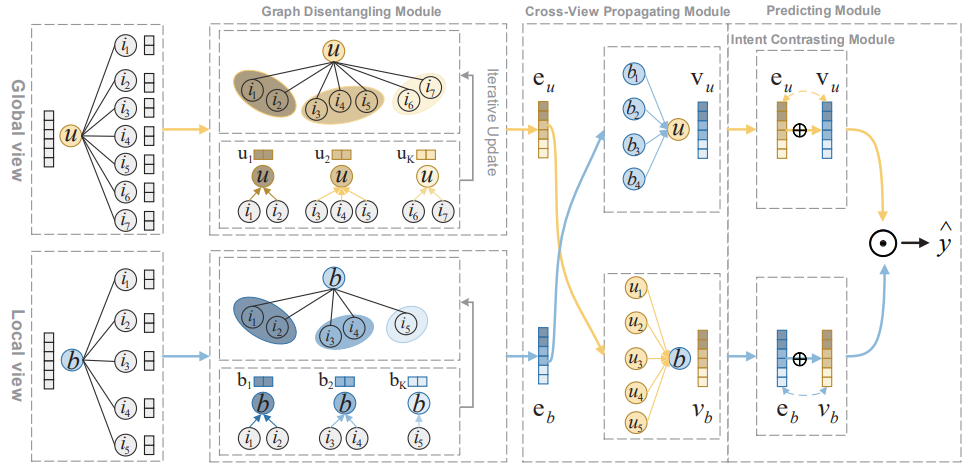

Are Graph Augmentations Necessary? Simple Graph Contrastive Learning for Recommendation

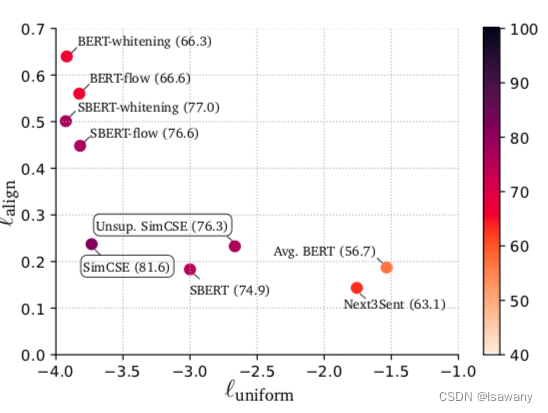

补充:特征对齐、均匀分布

Embedding里能够保留更多个性化的信息,这又代表什么呢?举个例子,比如有两张图片,都是关于狗的,但是一张是在草地上跑的黑狗,一张是在水里游泳的白狗。如果在投影成Emb…

CLIP 对比学习 源码理解快速学习

最快的学习方法,理清思路,找视频讲解,看源码逻辑: CLIP 源码讲解 唐宇

输入: 图像-文本成对配对的数据 训练模型的过程(自己理解):

怎么做的?:利用数据内部…

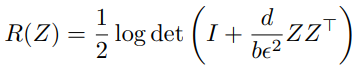

浅谈 EMP-SSL + 代码解读:自监督对比学习的一种极简主义风

论文链接:https://arxiv.org/pdf/2304.03977.pdf

代码:https://github.com/tsb0601/EMP-SSL

其他学习链接:突破自监督学习效率极限!马毅、LeCun联合发布EMP-SSL:无需花哨trick,30个epoch即可实现SOTA 主要…

InstDisc 代码解读

目录

Unsupervised Feature Learning via Non-Parametric Instance Discrimination 代码解读

0. 概览

1. lemniscate

1.1 lemniscate 的定义

1.2 NCEAverage

1.3 训练时,如何使用这个 NCEAverage 对象

1.4 NCEFunction

2. criterion Unsupervised Feature L…

【AI视野·今日NLP 自然语言处理论文速览 第七十二期】Mon, 8 Jan 2024

AI视野今日CS.NLP 自然语言处理论文速览 Mon, 8 Jan 2024 Totally 17 papers 👉上期速览✈更多精彩请移步主页 Daily Computation and Language Papers

DeepSeek LLM: Scaling Open-Source Language Models with Longtermism Authors DeepSeek AI Xiao Bi, Deli Ch…

pytorch-metric-learning度量学习工具官方文档翻译

基于Pytorch实现的度量学习方法

开源代码:pytorch-metric-learning官网文档:PyTorch Metric Learning官方文档

度量学习相关的损失函数介绍:

度量学习DML之Contrastive Loss及其变种度量学习DML之Triplet Loss度量学习DML之Lifted Structu…

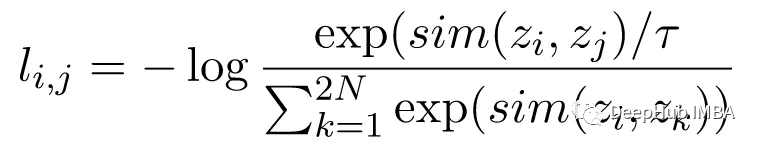

对比学习与simclr详解

对比学习(Contrastive Learning)是一种机器学习方法,旨在通过比较数据样本之间的相似性和差异性来学习有用的表示(特征)。其核心思想是通过将相似的样本映射到相邻的位置,将不相似的样本映射到远离的位置&a…

CRD3 小陈读paper

KD损失 比较常见了 对于源模态上的原始训练任务,此类数据没有真实标签 y,因此我们忽略我们测试的所有目标中的 H(y, yS ) 项。 这个比较适合看图 Experiments

我们在三个知识蒸馏任务中评估我们的对比表示蒸馏 (CRD) 框架:

(a&a…

论文笔记--SimCSE: Simple Contrastive Learning of Sentence Embeddings

论文笔记--SimCSE: Simple Contrastive Learning of Sentence Embeddings 1. 文章简介2. 文章概括3 文章重点技术3.1 对比学习 Contrastive Learning3.2 Unsupervised SimCSE3.3 Supervised SimCSE3.4 Anisotropy3.5 Alignment and Uniformity 4. 文章亮点5. 原文传送门6. Refe…

文献阅读:SimCSE:Simple Contrastive Learning of Sentence Embeddings

文献阅读:SimCSE:Simple Contrastive Learning of Sentence Embeddings 1. 文献内容简介2. 主要方法介绍3. 主要实验介绍 1. STS Experiment2. Downsteam Experiment 4. 讨论 1. loss function考察2. 其他正例构造方式考察3. 消解实验 5. 结论 & 思考…

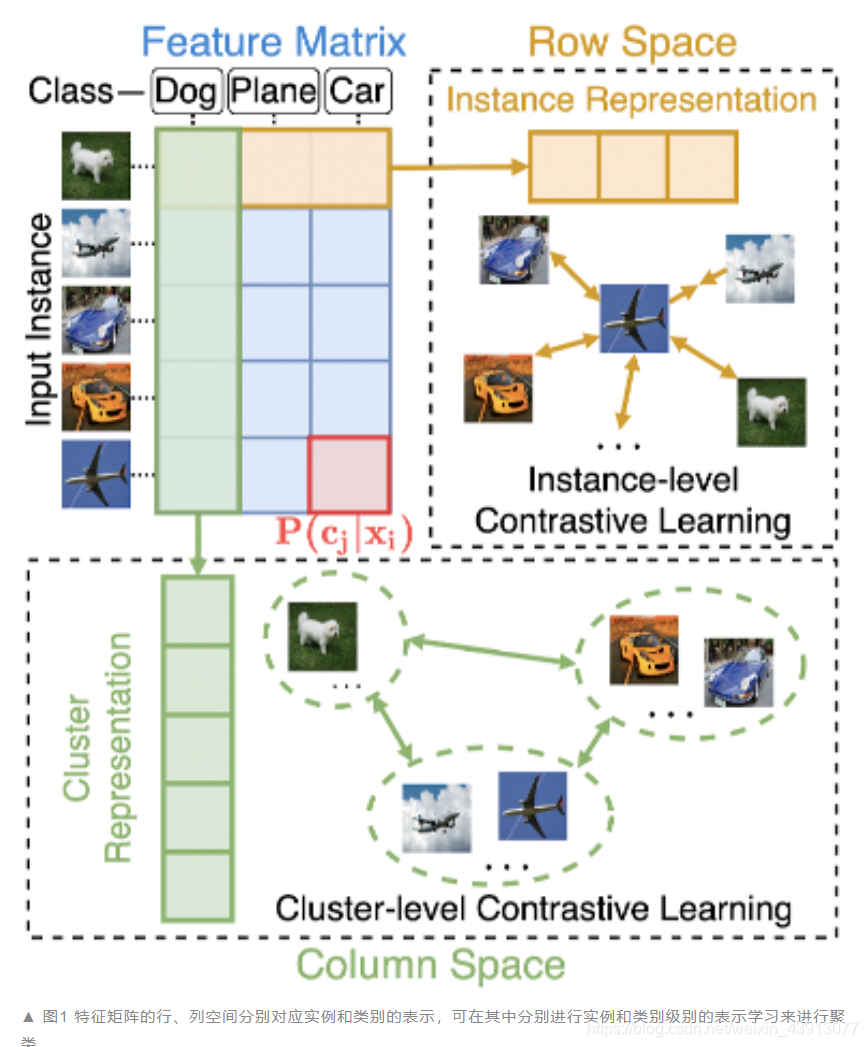

Contrastive Clustering

文章目录121

论文链接:AAAI 2021 博客链接:基于对比学习的聚类工作 现有的大部分深度聚类(Deep Clustering)需要迭代进行表示学习和聚类这两个过程。

算法过程:

对样本进行表示对样本进行聚类重复1和2

缺点&#x…

【论文阅读笔记】(2021 CVPR)3D Human Action Representation Learning via Cross-View Consistency Pursuit

写在前面

方法部分好多公式变量,编辑器再打一遍好麻烦。。。偷个懒,就直接把这部分的笔记导出成图片咯,并且我按我自己理解比较顺的逻辑重新捋了一下。 3D Human Action Representation Learning via Cross-View Consistency Pursuit

&…

【自监督学习】对比学习(Contrastive Learning)介绍

1. 前言

1.1. 为什么要进行自监督学习 我们知道,标注数据总是有限的,就算ImageNet已经很大,但是很难更大,那么它的天花板就摆在那,就是有限的数据总量。NLP领域目前的经验应该是:自监督预训练使用的数据量…

简单谈谈 EMP-SSL:自监督对比学习的一种极简主义风

论文链接:https://arxiv.org/pdf/2304.03977.pdf

代码:https://github.com/tsb0601/EMP-SSL

其他学习链接:突破自监督学习效率极限!马毅、LeCun联合发布EMP-SSL:无需花哨trick,30个epoch即可实现SOTA 主要…

【图神经网络 · 科研笔记5】异构信息网络,利用注意力选择元路径;利用进化邻域和社群实现自监督动态图嵌入,交叉监督对比学习;近期科研思维导图小汇总;

记录部分科研文献阅读相关内容【划重点】,主题“图神经网络”,仅学习使用。 🎯作者主页: 追光者♂🔥 🌸个人简介: 📝[1] CSDN 博客专家📝 🏆[2] 人工智能领域优质创作者🏆 🌟[3] 2023年城市之星领跑者TOP1(哈尔滨)🌿 🌿[4] 2022年度…

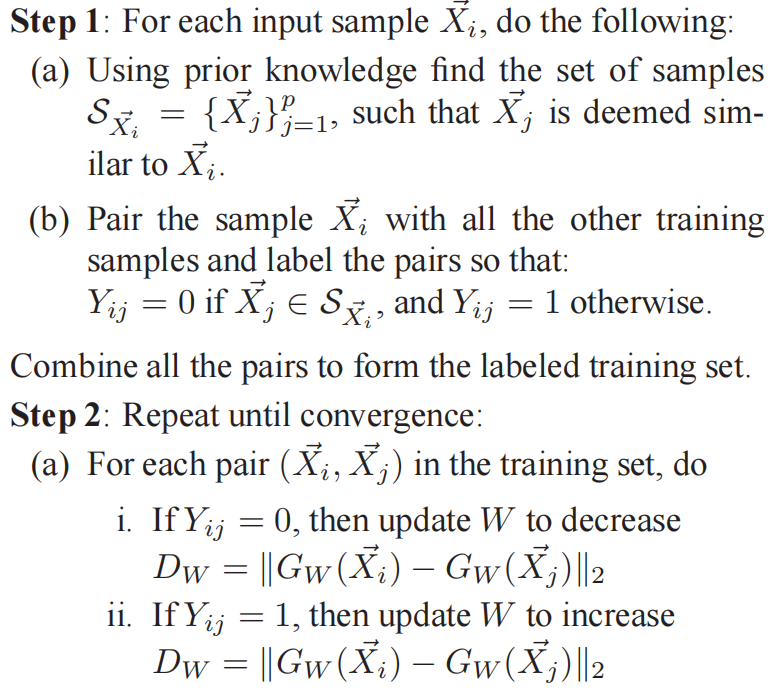

对比损失Contrastive Loss(CVPR 2006)原理解析

paper:http://yann.lecun.com/exdb/publis/pdf/hadsell-chopra-lecun-06.pdf 本文提出的对比损失contrastive loss被广泛应用于自监督模型中,但最初对比损失是作为一个特征降维方法而提出的。

摘要

降维是学习一种映射关系,通过这种映射关…

对比学习15篇顶会论文及代码合集,2023最新

对比学习(contrastive learning)是现在无监督学习中一种常用的学习机制,它可以在没有标签的数据上进行学习,避免依赖大量标签数据,从而帮助我们更好地理解和利用数据集中的信息,提高模型的性能和表现。

作…

使用Pytorch实现对比学习SimCLR 进行自监督预训练

SimCLR(Simple Framework for Contrastive Learning of Representations)是一种学习图像表示的自监督技术。 与传统的监督学习方法不同,SimCLR 不依赖标记数据来学习有用的表示。 它利用对比学习框架来学习一组有用的特征,这些特征…

对比学习的锚网络和自动生成标签

文章目录 锚网络自动生成标签(词组) 锚网络

在对比学习(Contrastive Learning)中,“锚网络”(Anchor Network)通常是指一个用于生成数据样本的表示的网络。锚网络的主要作用是将输入数据样本转…

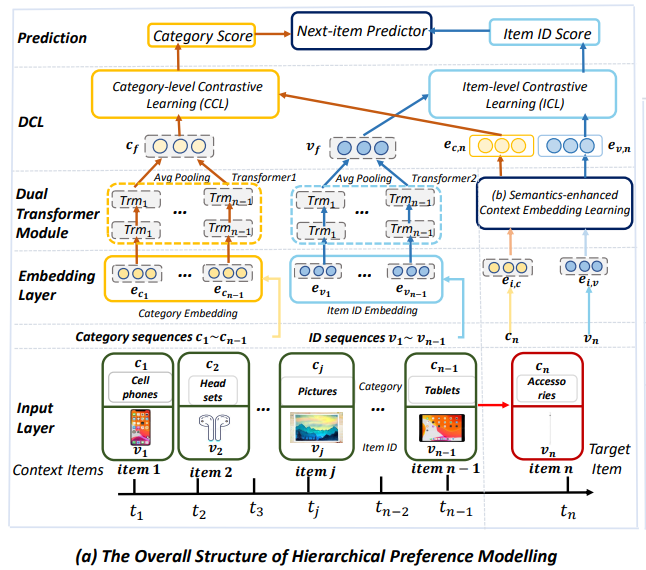

对比学习2024最新SOTA&应用方案分享,附14篇必读论文和代码

同学们发现没有,对比学习在我们的日常工作生活中已经很常见了,比如推荐系统任务,为用户推荐相似的商品或预测用户的购买行为;又比如图像检索,为用户找相似图片或识别不同物体。另外还有语音识别、人脸识别、NLP&#x…

Hi-TRS:骨架点视频序列的层级式建模及层级式自监督学习

论文题目:Hierarchically Self-Supervised Transformer for Human Skeleton Representation Learning

论文下载地址:https://www.ecva.net/papers/eccv_2022/papers_ECCV/papers/136860181.pdf

代码地址:https://github.com/yuxiaochen1103…

【论文速递】ACL 2021-CLEVE: 事件抽取的对比预训练

【论文速递】ACL 2021-CLEVE: 事件抽取的对比预训练

【论文原文】:CLEVE: Contrastive Pre-training for Event Extraction

【作者信息】:Wang, Ziqi and Wang, Xiaozhi and Han, Xu and Lin, Yankai and Hou, Lei and Liu, Zhiyuan and Li, Peng and …

如何只用bert夺冠之对比学习代码解读

有监督对比学习:Supervised Contrastive Learning: https://zhuanlan.zhihu.com/p/136332151

1. 自监督对比学习

一句话总结:不使用label数据,通过数据增强构造样本,使特征提取器提取的特征在增强样本和原始样本的距离更近&…

CRD2 值得一读的知识蒸馏与对比学习结合的paper 小陈读paper

一定要读 真的是不一样的收获啊

不知道 屏幕前的各位get到了没有

Hinton et al. (2015) introduced the idea of temperature in the softmax outputs to better represent smaller probabilities in the output of a single sample.

Hinton等人(2015)引入了softmax输出中温…

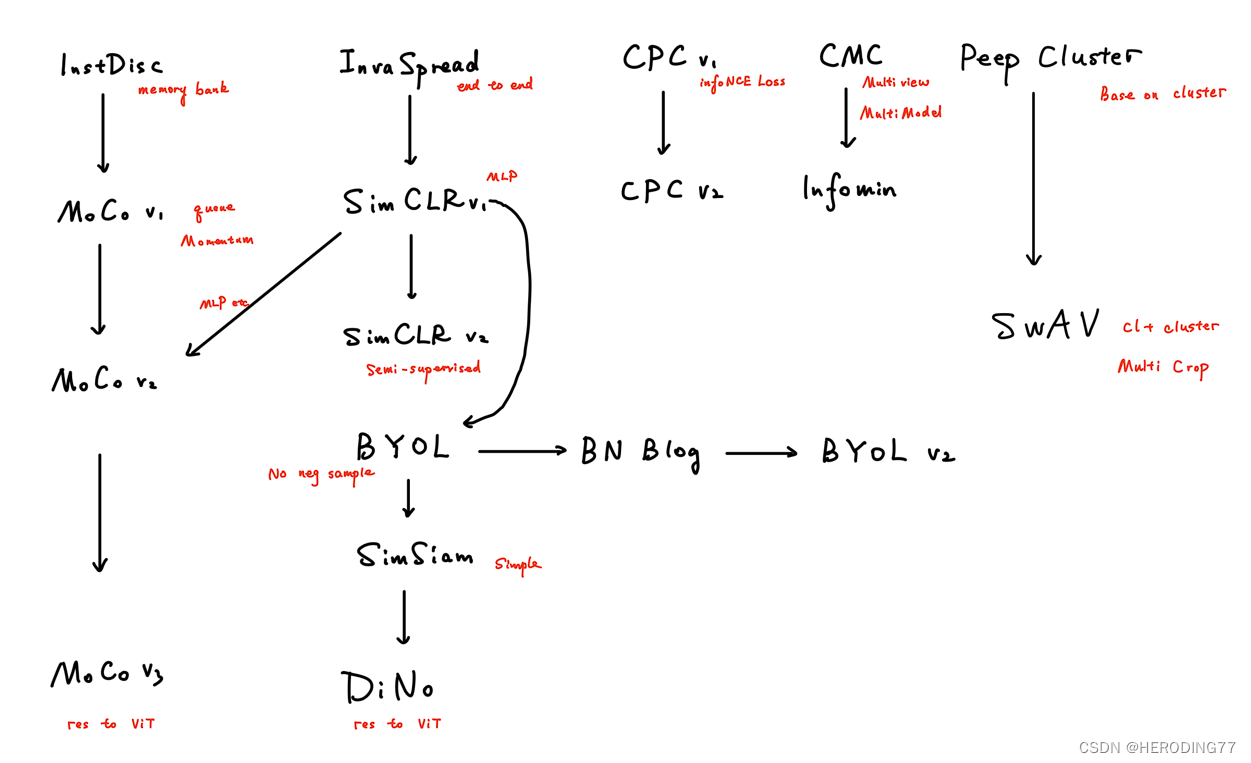

李沐论文精读系列三:MoCo、对比学习综述(MoCov1/v2/v3、SimCLR v1/v2、DINO等)

文章目录一、MoCo1.1 导言1.1.1 前言1.1.2 摘要1.1.3 导言1.2 相关工作1.2.1 SimCLR:端到端的学习方式(Inva Spread也是)1.2.2 memory bank (InstDisc模型)1.3 算法1.3.1 损失函数1.3.2 伪代码1.4 实验1.4.1 对比其他模…

论文笔记与实战:对比学习方法MOCO

目录 1. 什么是MOCO2. MOCO是干吗用的3. MOCO的工作原理3.1 一些概念1. 无监督与有监督的区别2. 什么是对比学习3. 动量是什么 3.2 MOCO工作原理1. 字典查找2. 如何构建一个好的字典3. 工作流程 3.3 (伪)代码分析 4. 其他一些问题5. MOCO v2和MOCO v35.1…

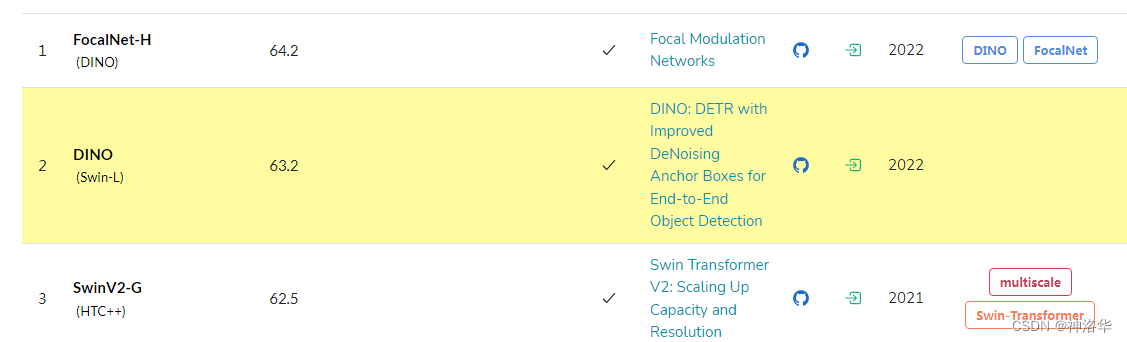

【学习笔记】计算机视觉对比学习综述

计算机视觉对比学习综述 前言百花齐放InstDiscInvaSpreadCPCCMC CV双雄MoCoSimCLRMoCo v2SimCLR v2SwAV 不用负样本BYOLSimSiam TransformerMoCo v3DINO 总结参考链接 前言

本篇对比学习综述内容来自于沐神对比学习串讲视频以及其中所提到的论文和博客,对应的链接详…

Socially-Aware Self-Supervised Tri-Training for Recommendation

摘要

自监督学习(SSL)可以从原始数据中自动生成真实样本,在改进推荐系统方面具有巨大的潜力。现有的基于ssl的方法通过节点/边dropout干扰原始数据图,生成新的数据视图,然后对不同视图进行基于对比学习的自识别,学习通用的表示。…