文章目录

- 前言

- 0、论文摘要

- 一、Introduction

- 1.1目标问题

- 1.2相关的尝试

- 1.3本文贡献

- 二.相关工作

- 三.本文方法

- 四 实验效果

- 4.1数据集

- 4.2 对比模型

- 4.3实施细节

- 4.4评估指标

- 4.5 实验结果

- 4.6 细粒度分析

- 五 总结

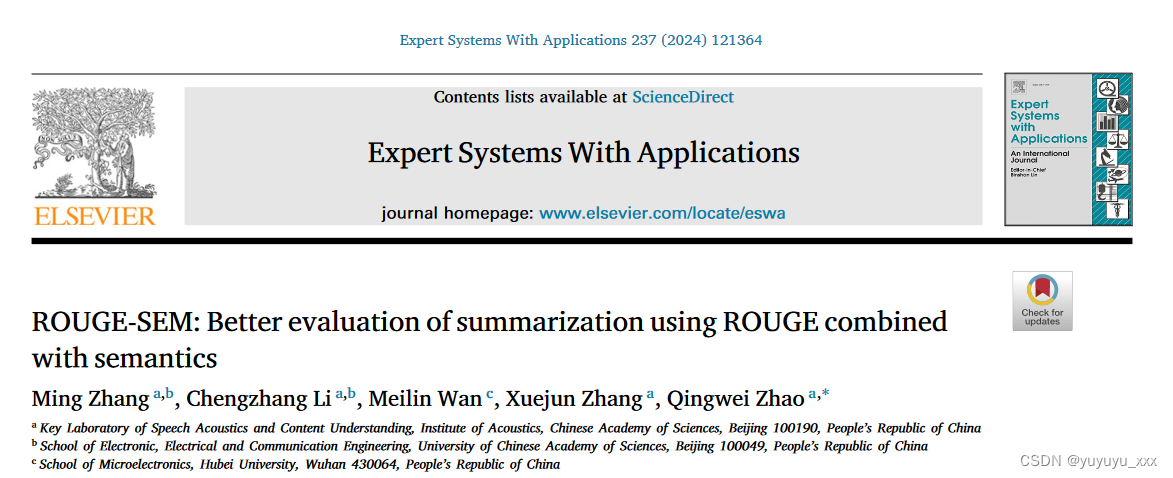

前言

ROUGE-SEM: Better evaluation of summarization using ROUGE combined with semantics(23)

0、论文摘要

随着预训练语言模型和大规模数据集的发展,自动文本摘要引起了自然语言处理界的广泛关注,但自动摘要评估的进展却停滞不前。尽管人们一直在努力改进自动摘要评估,但由于其具有竞争力的评估性能,ROUGE 近 20 年来仍然是最受欢迎的指标之一。

然而,ROUGE并不完美,有研究表明,它存在抽象摘要评估不准确和生成摘要多样性有限的问题,这都是由词汇偏差造成的。为了避免词汇相似性的偏差,人们提出了越来越多有意义的基于嵌入的度量,通过测量语义相似性来评估摘要。由于准确测量语义相似度的挑战,它们都无法完全取代 ROUGE 作为文本摘要的默认自动评估工具包。

为了解决上述问题,我们提出了一种折衷评估框架(ROUGE-SEM),用于利用语义信息改进ROUGE,通过语义相似度模块弥补语义意识的缺乏。根据语义相似度和词汇相似度的差异,首次将摘要分为四类:好摘要、珍珠摘要、玻璃摘要和坏摘要。

特别是,采用回译技术重写了ROUGE评估不准确的pearl-summary和glass-summary,以减轻词汇偏差。通过这个管道框架,摘要首先由候选摘要分类器分类,然后由分类摘要重写器重写,最后由重写的摘要评分器评分,以符合人类行为的方式进行有效评估。当使用 Pearson、Spearman 和 Kendall 等级系数进行测量时,我们的建议在连贯性、一致性、流畅性和相关性方面比几种最先进的自动摘要评估指标实现了与人类判断相当或更高的相关性。这也表明用语义改进 ROUGE 是自动摘要评估的一个有前途的方向。

一、Introduction

1.1目标问题

作为自然语言处理 (NLP) 最受关注的领域之一,自动文本摘要 (ATS) 已被广泛研究了数十年(El-Kassas、Salama、Rafea 和 Mohamed,2021;Garg 和 Kumar,2022;Xiao,何和金,2022)。特别是近年来,由于大规模数据集的引入(Cohen, Kalinsky, Ziser, & Moschitti, 2021; Fabbri, Li, She, Li, & Radev, 2019)以及预训练的提出,ATS 得到了快速发展。语言模型 (PLM)(Ghadimi & Beigy,2022;Mohd、Jan 和 Shah,2020;Xie、Bishop、Tiwari 和 Ananiadou,2022)。特别是,一个有效的自动摘要评估指标对于 ATS 来说将是一个巨大的福音,因为不仅可以将人们从耗时耗力的人工评价中解放出来,而且极大地促进了文本摘要的发展。

正如 Koto、Baldwin 和 Lau(2022)中提到的,ATS 的主流评估采用 ROUGE(Lin,2004),这是一种简单但有用的评估指标,用于计算候选摘要和参考摘要之间的重叠单位。然而,广泛使用的ROUGE对于自动摘要评估来说并不完美。 ROUGE因其直观、简单和易于计算而受到欢迎,但有研究指出它仍然存在缺陷(Lin et al., 2022; Schluter, 2017; ShafieiBavani, Ebrahimi, Wong, & Chen, 2018)。由于ROUGE可能通过测量候选摘要和参考摘要之间的词汇相似性而表现出词汇偏差(Ng&Abrecht,2015),因此它在评估ATS时具有以下局限性。首先,ROUGE 通常被认为不适合评估抽象摘要,因为它限制了生成摘要的多样性。众所周知,同一个源文档可以为具有不同知识或目的的人生成不同表达方式的多个摘要。然而,ROUGE 通过奖励具有较大词汇相似性的摘要并惩罚具有较小词汇相似性的摘要来限制生成摘要的多样性。其次,带有词汇偏差的ROUGE无法全面评估候选摘要。为了全面评估候选摘要,人工评估通常会考虑很多因素,包括冗余性、信息量和可读性等。然而,ROUGE本质上无法评估候选摘要的文本质量,因为它只考虑候选摘要之间的词汇相似度和参考摘要。具体来说,ROUGE 在连贯性和流畅性方面表现出更好的相关性,但在一致性和相关性方面表现出较差的相关性,这是基于词汇相似性的指标的常见问题。最后,ROUGE 已多次被证明与手动评估具有良好的相关性,但由于这些局限性,仍然有很大的改进空间。

为了改进自动摘要评估,人们做出了许多努力来解决 ROUGE 的上述局限性。一方面,一些研究通过同义词替换和释义对 ROUGE 进行了扩展,例如 ROUGE-WE (Ng & Abrecht, 2015)、ROUGE 2.0 (Ganesan, 2018) 和 ROUGE-G (ShafieiBavani et al., 2018)。另一方面,一些研究考虑了单词之间的语义关系来替代标准ROUGE。由于精确单词匹配的限制,近年来越来越多的基于语义嵌入的度量被提出,这些度量计算两个摘要的向量表示之间的相似度。作为基于语义嵌入的度量的早期代表,GM (Rus & Lintean, 2012)、VE (Forgues, Pineau, Larchevêque, & Tremblay, 2014) 和 SMS (Clark, Celikyilmaz, & Smith, 2019) 发挥了积极的作用在自动总结评价中。最近,Cao和Zhuge(2022)采用语义链接网络来评估候选摘要的保真度、简洁性和连贯性。尤其是随着PLM的快速发展,基于PLM的自动摘要评估研究引起了相当大的关注,例如MoverScore(Zhao et al., 2019)、BERTScore(Zhang, Kishore, Wu, Weinberger, & Artzi, 2020)和BARTScore(Yuan、Neubig 和 Liu,2021)。最近,SPEED(Akula & Garibay,2022)使用专门针对句子对任务进行预训练的句子级嵌入来计算两个文本的语义相似度。 Sem-nCG (Akter, Bansal, & Santu, 2022) 是一种基于增益的评估指标,它不仅具有语义意识,而且还根据句子的排名奖励摘要。此外,ENMS (He, Jiang, Chen, Le, & Ding, 2022) 利用语义信息来增强现有的基于 N-gram 的评估指标。由于获取参考摘要的困难,研究人员还提出了用于评估候选摘要的无参考指标,例如 SUPERT (Gao, Zhu, & Eger, 2020)、SDC* (Liu, Jia, & Zhu, 2022) 和 Shannon (伊根、瓦西里耶夫和博汉农,2022)。尽管不断努力改进自动摘要评估,但这些指标都不能完全取代 ROUGE 作为文本摘要的默认自动评估工具包,因为它已被反复证明与多个维度的人类判断良好相关。

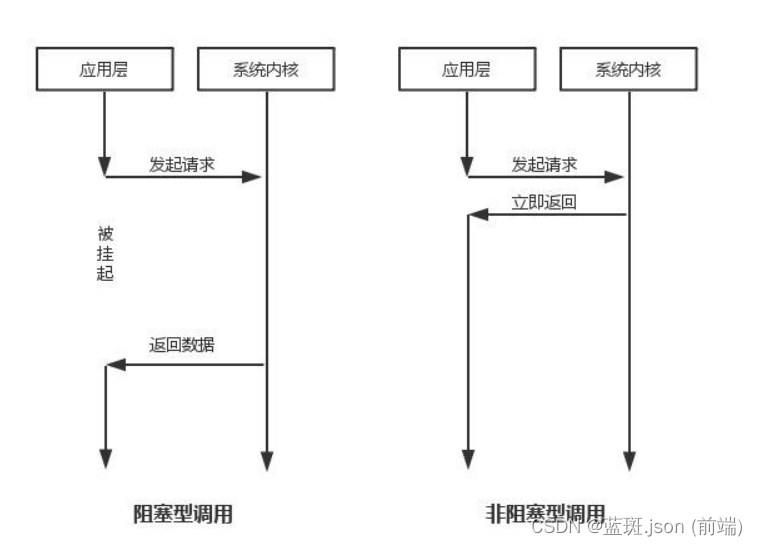

在本文中,我们提出了一种折衷方法来解决 ROUGE 的上述局限性,因为准确测量语义相似性具有挑战性。受到 ShafieiBavani 等人的启发。 (2018),我们提出了一种管道框架(ROUGE-SEM),该框架使用 ROUGE 结合语义信息进行自动摘要评估。具体来说,采用具有对比学习的Siamese-BERT网络作为语义相似度模块来弥补语义意识的缺乏。如图1所示,所提出的评估框架由候选摘要分类器、分类摘要重写器和重写摘要评分器。这些单独的组件构成了符合人类行为的管道方法,即首先利用语义和词汇相似性对候选摘要进行分类,然后重写难以评估的摘要,最后根据分类和重写的结果对摘要进行重新评分。

为了更直观地说明所提出的 ROUGE-SEM,我们提供了 DialSummEval 数据集中的一些典型示例。如图2所示,源文档、参考摘要和候选摘要分别显示在前三列中。第四列和第五列分别评估候选摘要在词汇或语义上是否与参考摘要相似。然后,候选摘要的类别显示在第六列中。第七列展示了反向翻译的结果。最后,最后两列分别显示标准 ROUGE-1/2/L 分数和建议的 ROUGE-SEM-1/2/L 分数。从图2中,我们观察到,根据语义和词汇相似度的差异,候选摘要被分为四类,包括goodsummary、pearl-summary、glass-summary和bad-summary。由于词汇偏差,ROUGE很难准确评估语义相关但不相似的珍珠摘要和语义不相关但相似的玻璃摘要。通过使用反向翻译技术重写上述摘要,我们可以通过更多样化的同义表达来减轻其对词汇相似性的偏见。这样,被低估的珍珠摘要有很高的概率获得较高的分数,而高估的玻璃摘要有很高的概率获得较低的分数。这就是为什么ROUGE-SEM是比传统ROUGE更有效的评估指标,它通过解决词汇偏差问题,显着提高了pearl-summary和glass-summary的评估性能。

为了验证我们提出的评估指标,对 SummEval (Fabbri, Kryściński, McCann, Xiong, Socher, & Radev, 2021) 和 DialSummEval (Gao & Wan, 2022) 进行了广泛的实验。特别是,Pearson、Spearman 和 Kendall 相关系数用于衡量评估表现的连贯性、一致性、流畅性和相关性。实验结果表明,ROUGE-SEM 的性能优于或相当几个最先进的总结评估指标。与成熟的 ROUGE 指标相比,无论使用何种相关性度量,所提出的评估指标在四个维度上都显示出与人类判断更高且更一致的相关性。这些令人兴奋的结果证实了使用语义来增强 ROUGE 的有效性,表明这是自动摘要评估的一个有前途的方向。

1.2相关的尝试

1.3本文贡献

总之,我们的贡献如下:

• 我们提出了一种新颖的摘要评估指标(ROUGESEM),它通过具有对比学习的Siamese-BERT网络弥补语义意识的缺乏,从而改进了传统的ROUGE。所提出的评估指标由三个单独的组件组成,包括候选摘要分类器、分类摘要重写器和重写摘要评分器。通过这个管道框架,摘要首先被分类,然后重写,最后评分,以符合人类行为的方式进行有效评估。

• 根据候选摘要和参考摘要在词汇相似度和语义相似度上的差异,我们引入了候选摘要的分类。它包括语义相关且词汇相似的good-summary、语义相关但词汇不相似的pearl-summary、语义不相关但词汇相似的glass-summary、语义不相关且词汇不相似的bad-summary。我们相信这将有利于自动摘要评估的进展,特别是提供改进基于词汇重叠的度量的潜力。

• 我们在两个基准数据集上进行实验来验证ROUGE-SEM 的有效性。

实验结果表明,我们提出的指标优于或与 SummEval 和 DialSummEval 数据集上的几种最先进的摘要评估指标相当,这表明这是自动摘要评估的一个有前途的方向。我们还分享了拟议的 ROUGE-SEM,以促进文本摘要系统的未来工作。

二.相关工作

由于文本摘要的手动评估对于大规模数据集并不实用,因此自动摘要评估引起了研究人员的广泛关注(Deutsch, Dror, & Roth, 2021;Shapira, Pasunuru, Ronen, Bansal,Amsterdamer, & Dagan, 2021;Wang ,Otmakhova、DeYoung、Truong、Kuehl、Bransom 和 Wallace,2023;Zhao 和 Lui,2022)。到目前为止,已经使用了多种指标来衡量文本摘要系统的性能。近年来提出的自动摘要评估指标概述如表1所示。本节介绍ATS评估的相关工作,分为外在评估和内在评估两类。

三.本文方法

四 实验效果

4.1数据集

4.2 对比模型

4.3实施细节

4.4评估指标

4.5 实验结果

4.6 细粒度分析

五 总结

在本文中,我们提出了一种新的评估指标ROUGE-SEM,它通过结合语义信息来增强流行的ROUGE。为了实现这一目标,候选摘要分类器、分类摘要重写器和重写摘要评分器作为主要组件以符合人类行为的方式构成了管道框架。具体地,候选摘要分类器采用语义相似度模块来计算语义相似度,并使用词汇相似度模块来计算候选摘要和参考摘要之间的词汇相似度。然后,根据语义相似度和词汇相似度的差异,将候选摘要分为四组,包括好摘要、珍珠摘要、玻璃摘要和坏摘要。对于ROUGE错误评估的pearl-summary和glass-summary,分类摘要重写器采用回译技术,通过更多样化的同义表达来减轻词汇偏差。最后,重写摘要评分器根据候选摘要分类器和分类摘要重写器的结果输出更准确的评估分数。实验结果表明,ROUGE-SEM 的性能可与现有的强基线和广泛使用的指标(使用三个系数测量)相媲美。特别是,ROUGE-SEM 的变体始终优于 ROUGE 的相应变体。

在未来的工作中,我们将采用一些特定于任务的预训练语言模型作为语义编码器,以实现更准确的语义相似度。我们将考虑用各种文本生成模型替换反向翻译模块以进行离线评估。此外,我们将采用更高效的参数优化策略进行参数调优。最后,我们将应用建议的指标来评估现有的基线和最先进的总结器。我们希望这项工作能够对未来文本摘要系统的研究产生积极的影响。